قبرصي: اليوتيوبر يتعرض لعملية احتيال، فينتقم في مقطع فيديو

13 أبريل 2024 الساعة 3:59 مساءً بتوقيتغير عادي

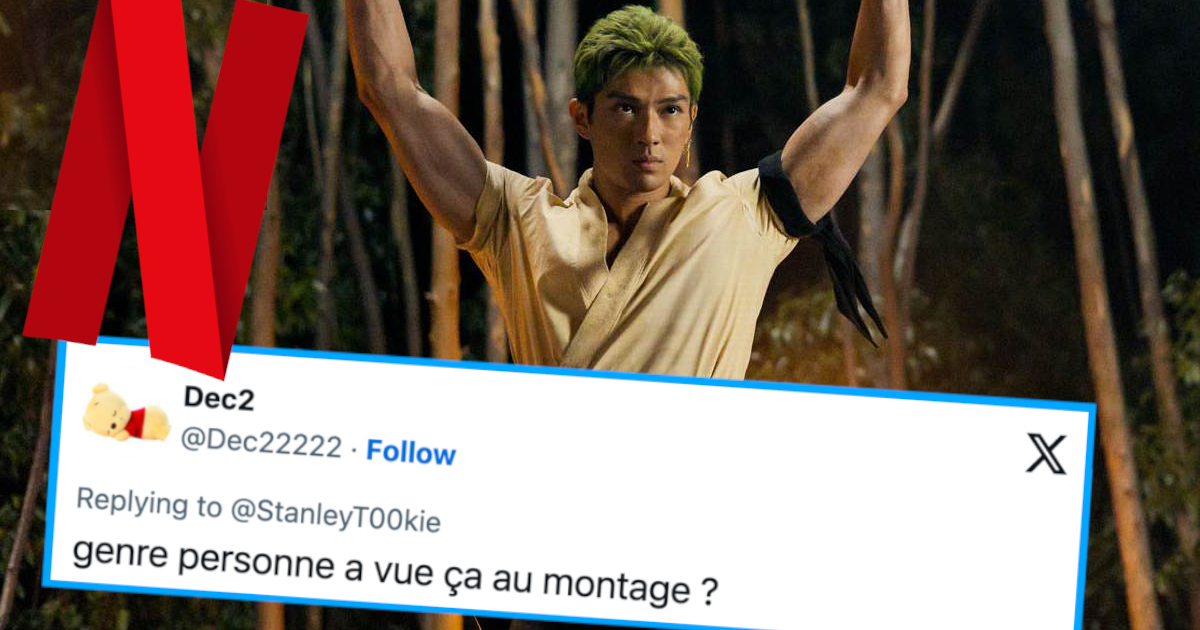

المزيد والمزيد من عمليات الاحتيال باستخدامl'IAوتقنيات Deepfakeتعميم علىالشبكات الاجتماعيةالآن. هؤلاءإعلانات كاذبةيستخدمصوت ووجه النجوم والمؤثرين مثل صوت YouTuber Cyprienلتوليدمرورودعوةالضحاياأن ينخدع.

Deepfake: الذكاء الاصطناعي وعمليات الاحتيال الواقعية بشكل متزايد

لقد تعرض الذكاء الاصطناعي لانتقادات شديدة لعدة سنوات، وهو محق في ذلك.تطورها هائل للغاية ومن الصعب التنبؤ بأي قمم،ما هي الدقة التي يمكنهم تحقيقها في غضون سنوات قليلة. إن الغموض القانوني المتعدد والجهل العام بها يدعو المحتالين وغيرهم من المحتالين إلى زيادة استخدامها للإيقاع بالأشخاص الحساسين بفضلصور تم إنشاؤها بواسطة الذكاء الاصطناعي والتي تولد وتستخدم أصوات ووجوه نجوم مثل Elise Lucet وNota Bene وFeldup وSqueezie وCyprien، الذي قرر تسليط الضوء على هذه الممارسة من خلال عمل فيديو مؤثر. ويظهر في الفيديو معاناة هو وفريقه الإبداعي من ظهور مقاطع فيديو تم إنشاؤها بواسطة الذكاء الاصطناعي قادرة على جعله يقول أي شيء.

نحن نهدأ بالذكاء الاصطناعي، أليس كذلك؟ لا أستطيع تحمل هذه الإعلانات بعد الآن... لا تنخدع بهذا الاحتيالpic.twitter.com/a5JKAyrqfD

- سيبريان (@MonsieurDream)12 أبريل 2024

في هذا الفيديو الفكاهييعود Cyprien إلى مظهر إعلان تم عرضه منذ خمسة أشهر على الأقل يحاكي خبرًا تلفزيونيًا يقدم ما يسمى بالتطبيق الثوري لكسب المال الذي أنشأه بنفسه. بالطبع، لا شيء من هذا صحيح، لم يقم Cyprien أبدًا بإنشاء هذا التطبيق أو الترويج لهذا الإعلان (ولكنقام بإنشاء تعويم الكرنفال الجميل الخاص به). والأسوأ من ذلك أن التنسيق المستخدم هو أيضًا إلى حد ما مماثل لعدد كبير من عمليات الاحتيال المرئية على الإنترنت، لأنه قابل للتبديل حسب الرغبة بفضل الذكاء الاصطناعي. ربما تكون قد شاهدت هذه الصور بالفعل، ولكن مع شخصيات أخرى تتحدث بدلاً من قبرصي.على الرغم من أنه قد يبدو من السهل اكتشاف الخداع، إلا أنك لن تكون في مأمن أبدًا من لحظة الضعف على الإنترنت. لمعرفة كيفية حماية نفسك من هذه الأنواع من الصور، من الأفضل التدرب على اكتشاف الأدلة التي يمكنها التعرف على مقاطع الفيديو التي تم إنشاؤها بواسطة الذكاء الاصطناعي.في الوقت الحالي، ما زالوا يواجهون صعوبة في إنشاء الحركات والخلفيات لمقاطع الفيديو التي تم إنشاؤها. ولمساعدتك على تجنب التعرض للخداع مرة أخرى، قام Youtuber Defakator بعمل مقطع فيديو طويل عنهم يمثل بوضوح المخاطر وطرق حماية نفسك من عمليات الاحتيال التي ينشئها الذكاء الاصطناعي.